如何评价 Meta 新论文 Transformers without Normalization?

Normalization这个事得好好掰扯掰扯。 上古时期,网络经常在初始几个iteration之后,loss还没下降就不动,必须得把每一层的gradient与weight的比值打印出来,针对性地调整每一层的初始 …

大模型 (LLM) 中常用的 Normalization 有什么? - 知乎

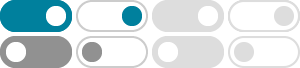

LayerNorm 其实目前主流的 Normalization 有个通用的公式 其中, 为均值, 为归一化的分母,比如对 LayerNorm 来说他是标准差,对 WeightNorm 来说是 L2 范数。 和 为可学习的参数,可 …

如何评价Kaiming He的Transformers without Normalization?

Therefore, we consider activations of a neural network to be normalized, if both their mean and their variance across samples are within predefined intervals. If mean and variance of x are …

Transformer 为什么使用 Layer normalization,而不是batchNorm?

Feb 13, 2023 · Layer Normalization 是对 单个样本的所有维度 特征做归一化。 在 NLP 中相当于对 一个 batch 内的 每个句子内所有位置的词 做归一化 6.4 BN 和 LN 的关系 BN 和 LN 都可以比 …

如何理解Normalization,Regularization 和 standardization?

May 16, 2017 · 如何理解Normalization,Regularization 和 standardization? 我知道的是:normalization和standardization是降低极端值对模型的影响. 前者是把数据全部转成从0-1; …

如何理解归一化(Normalization)对于神经网络(深度学习)的帮 …

在深度学习中,归一化的手段可谓无处不在。对神经网络的输入进行归一化,对每一层的归一化(Batch Normal…

z-score 标准化 (zero-mean normalization) - 知乎

最常见的标准化方法就是 Z标准化,也是 SPSS 中最为常用的标准化方法,spss默认的标准化方法就是z-score标准化。 也叫 标准差 标准化,这种方法给予原始数据的均值(mean)和标准 …

深度学习中 Batch Normalization为什么效果好? - 知乎

Normalization是一个统计学中的概念,我们可以叫它 归一化或者规范化,它并不是一个完全定义好的数学操作 (如加减乘除)。 它通过将数据进行偏移和尺度缩放调整,在数据预处理时是非常 …

深度学习中Batch Normalization和Dice激活函数 - 知乎

其一是在做 batch normalization 的时候,训练的时候没有更新参数,其二就是 Dice 激活函数在预测的时候实现的有问题,修复后, auc 有明显的提升 (大概有 1% 的提升,在ctr预估场景,这 …

CNN为什么要用BN, RNN为何要用layer Norm? - 知乎

Normalization 不管是 Batch Normalization 还是 Layer Normalization, Normalization的目的是为了把输入转化成均值为0方差为1的数据。 换句话说,这里的 Normalization 其实应称为 …